Sommario

Dalla business intelligence ai sistemi di predictive analytics

I processi di analisi dei dati hanno subito numerose trasformazioni che evidenziano un processo di continua evoluzione delle tecniche e delle metodologie impiegate. Seguiamo il percorso evolutivo dell’analisi dei dati in azienda, capendo come da semplici query su tabelle relazionali si è passati a sistemi di business intelligence (BI) e come gli strumenti di predictive analytics rappresentino oggi la naturale estensione della BI.

Dall’OLTP alla business intelligence

Già a partire dagli anni sessanta, le tecnologie disponibili consentivano la raccolta dei dati riguardanti i processi aziendali su supporti magnetici quali nastri e dischi. Le analisi che potevano essere svolte erano statiche e limitate ad estrazioni dei dati di consuntivo. Le analisi erano svolte su grandezze aggregate: per esempio era possibile conoscere l’ammontare delle vendite dell’ultimo semestre o dell’ultimo anno. Con l’avvento dei database relazionali e del linguaggio SQL, negli anni ottanta, l’analisi dei dati assume una certa dinamicità: l’SQL consente di estrarre in maniera semplice i dati, sia in modo aggregato, sia a livello di massimo dettaglio. Le attività di analisi avvengono sulle basi dati operazionali, ovvero quelle su cui i è registrata l’attività operativa giornaliera dell’azienda; si tratta per esempio di applicativi per la gestione degli ordini, per la contabilità, per la gestione del personale e delle paghe, per la fatturazione, ecc.

Nella migliore delle ipotesi, ciascuno degli applicativi appena descritti, è semplicemente un modulo di un software ERP (Enterprise Resource Planning), acquistato “chiavi in mano” da un produttore come SAP, Microsoft oppure Oracle. In questo caso l’applicazione ERP è una sola e ricomprende tutti gli aspetti della gestione aziendale, garantendo uniformità e coerenza nel trattamento dei dati.

Purtroppo, nella maggioranza dei casi, accade che non vi sia un’unica applicazione che gestisce le attività del livello operativo. Ci si trova spesso di fronte ad una pletora di software ognuno dei quali è basato su tecnologie differenti (database relazionali, basi dati non relazionali) e su prodotti di vendor diversi. In presenza di numerose applicazioni, l’uniformità e la coerenza dei dati non sono per nulla garantite, poiché ci si trova in una situazione in cui dati fondamentali, quali le anagrafiche (clienti, fornitori, prodotti, piano dei conti, …), sono replicati e manipolati in ciascuno dei software, presentando differenze di formati, di completezza o aggiornamento dei dati. Un altro aspetto da tenere in considerazione riguarda il disegno delle basi dati sottostanti agli applicativi operazionali. Esse sono di tipo OLTP (On Line Transaction Processing), il loro modello dati è fortemente normalizzato per favorire non tanto le letture e l’analisi di grandi quantità di record, quanto le attività transazionali (inserimenti, cancellazioni, modifiche dei dati). La normalizzazione, se da un lato favorisce l’attività transazionale, dall’altro incrementa notevolmente il numero di tabelle utilizzate per contenerli. Per ricostruire un formato tabellare denormalizzato, più adatto ad essere letto da un utente finale, occorreranno diverse operazioni di JOIN, che complicano l’attività di estrazione dei dati. Oltre a quanto detto sopra, bisogna considerare che solitamente i sistemi operazionali offrono una limitata profondità storica dei dati e, a volte, essa manca del tutto. Molto spesso, anche in presenza di dati storici, risulta complesso ricostruire la situazione dei dati nel passato.

L’insieme dei fattori appena descritti rende piuttosto difficoltosa l’analisi dei dati effettuata direttamente sulle fonti operazionali. E’ per questo motivo che, a partire dagli anni novanta, si è cominciato a creare database disegnati appositamente per le analisi e ad integrare in essi i dati provenienti dai sistemi operazionali. Nasce così il data warehouse, un database che contiene dati integrati, consistenti e certificati afferenti tutti i processi di business dell’azienda (o per lo meno alla maggior parte di essi) e che costituisce il punto di partenza per le attività analitiche del sistema di Business Intelligence (BI). La Business Intelligence è un sistema di modelli, metodi, processi, persone e strumenti che rendono possibile la raccolta regolare ed organizzata del patrimonio dati generato da un’azienda. Inoltre attraverso elaborazioni, analisi o aggregazioni, ne permette la trasformazione in informazioni, la loro conservazione, reperibilità e presentazione in una forma semplice, flessibile ed efficace, tale da costituire un supporto alle decisioni strategiche, tattiche ed operative.

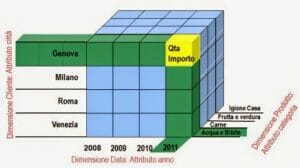

Con l’evoluzione dei sistemi di BI si è passati da analisi effettuate sul data warehouse tramite query SQL a basi dati multidimensionali che fondono dati e metadati, consentendo all’analista di fare a meno di conoscenze tecniche relative ai database e di concentrarsi sulle problematiche di business. La base dati OLAP consiste in una struttura multidimensionale chiamata cubo, anche se, in realtà, si tratta di un ipercubo, avendo quasi sempre più di tre dimensioni. Se semplifichiamo la struttura del database utilizzando soltanto tre dimensioni di analisi è possibile immaginare e rappresentare graficamente il database OLAP, come rappresentato nella figura seguente:

Dalla business intelligence ai sistemi di predictive analytics

La nascita dei sistemi OLAP (On Line Analytical Processing) ha reso semplice la navigazione dei dati attraverso operazioni di drill down o drill-up, slicing e dicing. Tuttavia si tratta sempre di una visione storica, che consente soltanto una valutazione a consuntivo di ciò che è accaduto nel passato, oppure di ciò che sta accadendo ora.

Più di recente ha cominciato ad affermarsi la necessità di effettuare analisi previsionali, per anticipare gli eventi e ottenere un vantaggio di business. Le tecniche di analisi, a cui ci riferiamo, prendono il nome di data mining, poiché consentono di “scavare” nei dati ed estrarre informazioni, pattern e relazioni non immediatamente identificabili e non note a priori. L’utilizzo delle tecniche di data mining volte all’impiego dei pattern a fini previsionali è chiamato predictive analytics.

Gli strumenti di predictive analytics possono essere utilizzati in qualsiasi settore economico, per risolvere molteplici problemi di business, come per esempio:

- Ricerca di anomalie. Il data mining può essere impiegato per l’identificazione di comportamenti fraudolenti nell’utilizzo di carte di credito.

- Churn Analysis. La churn analysis consiste nell’analisi della clientela per determinare i clienti che presentano un’alta probabilità di passare alla concorrenza, al fine di intervenire in anticipo ed evitarne la migrazione.

- Segmentazione della clientela. Le tecniche di segmentazione possono essere utili, per esempio, a determinare il profilo comportamentale dei clienti. Una volta identificati i segmenti di clienti simili, è possibile studiare strategie di marketing differenziate per ciascun gruppo.

- Previsioni su serie temporali. Le analisi predittive dell’andamento delle vendite, o, genericamente dell’andamento di serie temporali, sono un altro degli ambiti di impiego del data mining.

- Campagne pubblicitarie mirate. L’utilizzo del data mining nell’ambito delle campagne di marketing mirate, consente di stabilire a priori quali siano, tra i prospect, quelli con maggior probabilità di acquistare i prodotti dell’azienda, in modo da impiegare su di essi le risorse del marketing.

- Market basket analysis. Le tecniche di market basket analysis sono utili a suggerire, a un certo cliente, ulteriori prodotti da acquistare in base ai suoi comportamenti d’acquisto abituali, oppure a definire il layout dei prodotti sugli scaffali.

Gli strumenti di predictive analytics devono essere inseriti in un processo che presuppone le seguenti fasi:

- Comprensione del business

- Comprensione dei dati

- Preparazione / pulizia dei dati

- Creazione di un modello predittivo

- Test e valutazione del modello

- Utilizzo del modello

Come si noterà i prime tre punti fanno già parte dell’implementazione di un sistema di business intelligence. Detto in altre parole, la presenza di un sistema di BI, che presuppone la presenza di un data warehouse con dati puliti e certificati, costituisce un’ottima base di partenza per l’implementazione di modelli predittivi. Occorre precisare che i dati così come li possiamo trovare nel data warehouse, devono comunque subire alcune trasformazioni per poter essere efficacemente impiegati negli algoritmi di data mining. Tali trasformazioni sono necessarie per soddisfare requisiti di funzionamento degli algoritmi (per es: normalizzazioni, trasformazioni di variabili descrittive, ecc.).

Le tecniche di predictive analytics rappresentano dunque la naturale evoluzione dei sistemi di business intelligence: da un lato le aziende che hanno già un sistema di BI riescono meglio a comprendere le potenzialità offerte dall’implementazione di tali tecniche; in più vi è la consapevolezza di essere a metà dall’opera, avendo a disposizione una base dati aggiornata, pulita e certificata.

Anche il mercato degli strumenti di predictive analytics è in fermento: accanto a strumenti che da tempo sono presenti sul mercato, vi sono nuove implementazioni, in particolare basate su soluzioni cloud e/o integrate con sistemi di gestione di big data. Azure Machine Learning di Microsoft costituisce un esempio sia delle soluzioni basate sul cloud, sia delle soluzioni legate ai big data, poiché può interagire con HDInsight, la piattaforma Hadoop presente su Azure. Altri esempi sono Apache Mahout, tool open source facente parte dell’”ecosistema” Hadoop, R (lo strumento free per l’analisi statistica e molto altro) con i suoi package dedicati al data mining e KNIME, altro software free.

Predictive Analytics e big data

Abbiamo appena fatto un cenno all’utilizzo di strumenti predittivi sui big data. Facciamo dunque un rapido cenno all’argomento, notando come spesso gli strumenti di predictive analytics sono associati ai big data e viceversa. Sicuramente l’utilizzo di tecniche efficienti di calcolo in grado di recuperare pattern nascosti, può dimostrarsi estremamente utile su moli di dati rilevanti, che spesso sono costituiti da: livello di dettaglio di transazioni quali acquisti nella GDO, movimenti di conti correnti bancari, log dei web server. Piattaforme quali Hadoop sono utili al fine di conservare dati di massimo dettaglio a costi limitati e possono quindi essere utilizzati come fonte per un processo di data mining. Occorre però ricordare che anche tali dati devono subire processi di pulizia e adattamento agli algoritmi, prima di poter essere impiegati nella costruzione di modelli predittivi.

Predictive analytics e self service business intelligence

Molto spesso la preparazione di un dataset per l’analisi predittiva presuppone un lavoro di data discovery e di integrazione dei dati aziendali anche con fonti esterne. Gli strumenti di self service business intelligence possono essere efficacemente utilizzati nella preparazione dei dati, in particolare nella fase esplorativa, ovvero nella fase in cui l’analista sta studiando i dati ed il problema di business. In questa fase l’analista deve, attraverso un processo iterativo, preparare i dati, scegliere un algoritmo di calcolo, definirne i parametri e valutare il risultato nel modello così costruito. Risulta ovvio che tale processo non può essere svolto all’interno del sistema di corporate business intelligence, data l’estrema flessibilità necessaria sia nella scelta delle fonti dati sia nella preparazione degli stessi. Una volta consolidate le fonti dati ed il modello predittivo, il processo di acquisizione, pulizia e trasformazione dei dati può essere “istituzionalizzato” e integrato nel sistema di BI aziendale, assumendo le caratteristiche di un processo sistematico, automatico e controllato.

Il ROI dei sistemi di predictive analytics

L’implementazione di sistemi di predictive analytics ha naturalmente un costo legato all’attività di analisi, preparazione dei dati e predisposizione del modello predittivo. Come fare a valutare se l’investimento si ripagherà? E in quanto tempo?

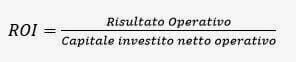

Per valutare il rendimento di un tale investimento utilizziamo la formula del ROI (Return On Investments)

Il ROI è uno degli indici di valutazione maggiormente usati in azienda. Come si può intuire dal nome, esso calcola la redditività del capitale investito nell’impresa e la sua formula è:

Il risultato operativo è il risultato economico della sola gestione caratteristica di un certo esercizio, mentre il capitale investito netto operativo è il totale degli investimenti direttamente riguardanti l’attività al netto di ammortamenti e accantonamenti.

Questa definizione, molto legata alla pratica contabile aziendale deve essere adattata allo scopo della valutazione della sistema di predictive analytics. Potremmo definire il ROI della sistema di p.a. con la seguente espressione:

Siccome sia una parte dei costi, sia una parte dei benefici si manifestano nel corso di più esercizi, occorre tener presente la componente temporale

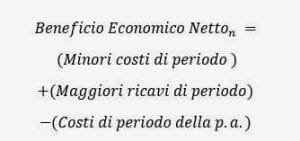

Definiamo i benefici economici di un singolo periodo come:

dove n indica un generico periodo.

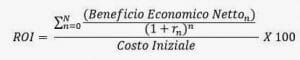

Una volta identificate le voci di costo e di beneficio, possiamo procedere con il calcolo delle misure economiche: ROI e periodo di payback.

Il calcolo del ROI avviene come rapporto tra il valore attuale dei benefici economici netti e il costo iniziale:

Dove:

n è il periodo

rn è il tasso di riferimento per quel periodo

Il ROI esprime in termini percentuali il ritorno avuto, nel periodo considerato, dall’investimento totale.

Il termine che troviamo al numeratore della formula è detto Net Present Value (valore attuale netto) e rappresenta il valore al tempo iniziale dei futuri benefici economici al netto dei costi ricorrenti.

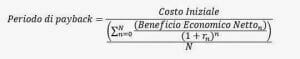

Manipolando la formula del ROI, otteniamo il periodo di payback, cioè il numero di anni necessari a ripagare l’investimento:

Nel presentare la formula del beneficio economico, non abbiamo parlato delle componenti che concorrono a formare i maggiori ricavi, i minori costi e i costi ricorrenti del sistema di p.a.

Cominciamo da questi ultimi: essi sono determinati dalle attività di manutenzione del modello, eventuali aggiornamenti del software, costo dell’analista che ce ne occupa.

I maggiori ricavi dipendono dal tipo di problematica che si affronta attraverso il sistema. Ecco alcuni esempi:

- Nel caso di operazioni di direct marketing, un modello predittivo può aiutare a determinare quali siano i prospect con maggior probabilità di effettuare un acquisto. Il modello aiuta quindi ad aumentare i ricavi di vendita, nel contempo diminuendo i costi delle attività di marketing, poiché esse sono limitate ai prospect con maggior probabilità.

- Nel caso di algoritmi di Fraud Detection, si ottiene una riduzione dei costi che si sopporterebbero se le attività fraudolente non venissero identificate e fermate.

- La manutenzione proattiva degli impianti di produzione, basata su modelli predittivi, consente notevoli risparmi rispetto alla manutenzione non programmata, da effettuarsi successivamente ad un guasto.

- Nel caso di modelli predittivi dei livelli di vendita, un vantaggio in termini di costi e di allocazione delle risorse può essere raggiunto calibrando gli approvvigionamenti di ciascun punto vendita sui risultati del modello.

- I modelli finalizzati ad aumentare il cross selling, hanno come effetto l’incremento dei ricavi di vendita.

- …

I minori costi o i maggiori ricavi sono stimabili sia attraverso simulazioni, sia attraverso l’esperienza del passato.

Conclusioni

I sistemi di predictive analytics rappresentano il passo successivo rispetto all’implementazione di sistemi di business intelligence. Questi ultimi forniscono la base dati di partenza per elaborare modelli predittivi. Tali modelli possono essere integrati con dati provenienti da fonti non ancora presenti nella corporate BI, magari attraverso strumenti di self service BI. I predictive analytics sono in grado di fornire vantaggi competitivi a chi li adotta, poiché sono in grado di creare una tangibile riduzione dei costi e/o un incremento dei ricavi, grazie in particolare ad una migliore allocazione delle risorse (di marketing, logistiche, …) o ad una più rapida identificazione di problemi (comportamenti fraudolenti, guasti a macchinari,…).

Leave A Comment