Sommario

Quali sono le caratteristiche dei big data?

I big data sono disponibili in enormi volumi, si presentano con formati destrutturati e caratteristiche eterogenee e sono spesso prodotti a velocità estrema: i fattori che li identificano sono dunque primariamente Volume, Variety, Velocity (volume, varietà e velocità).

Analizziamo meglio questi tre parametri:

Volume

Equivale alla quantità dei big data, sia che essi siano stati generati dagli utenti sia che, in maniera automatica, da macchine. Big data come transazioni bancarie e movimenti sui mercati finanziari assumono naturalmente valori mastodontici che non possono in alcun modo essere gestiti con i tradizionali strumenti database. Possiamo ricondurre il volume dei dati generati da una azienda all’ordine di grandezza di terabyte o petabyte.

Variety

E’ la seconda caratteristica dei big data, e riguarda la diversità dei formati e, spesso, l’assenza di una struttura rappresentabile attraverso una tabella in un database relazionale. La varietà dei big data è dovuta anche alla loro mancata strutturazione: tra essi sono infatti inclusi anche documenti di vario genere (txt, csv, PDF, Word, Excel, ecc.), blog post, commenti sui social network o sulle piattaforme di microblogging come Twitter. I big data sono vari anche nelle fonti: alcuni sono generati automaticamente da macchine, come i dati provenienti da sensori o i log di accesso a un sito web o quelli del traffico su un router, altri sono generati dagli utenti del web.

Velocity

E’ la velocità con cui i nuovi dati si rendono disponibili il terzo fattore di identificazione dei big data, e proprio in funzione di questo parametro è necessario l’utilizzo di strumenti in grado di garantirne il corretto immagazzinamento. Tra le tecnologie capaci di gestire i dati “ad alta velocità” vi sono i database historian (per l’automazione industriale) e quelle denominate streaming data o complex event processing (CEP), come Microsoft StreamInsight, un framework per lo sviluppo di applicazione di complex event processing che consente di monitorare più fonti di dati, analizzando questi ultimi in modo incrementale con una bassissima latenza. Le applicazioni CEP sono applicate con successo anche negli ambiti industriale, scientifico, finanziario e in quello relativo all’analisi degli eventi generati sul web.

Ad oggi, i Big Data possono essere caratterizzati da tre ulteriori discriminanti:

variabilità: una caratteristica riferita alla possibile inconsistenza dei dati analizzati;

complessità: che aumenta in maniera direttamente proporzionale alla dimensione del dataset;

veridicità: relativa al valore informativo che è possibile estrarre dai dati.

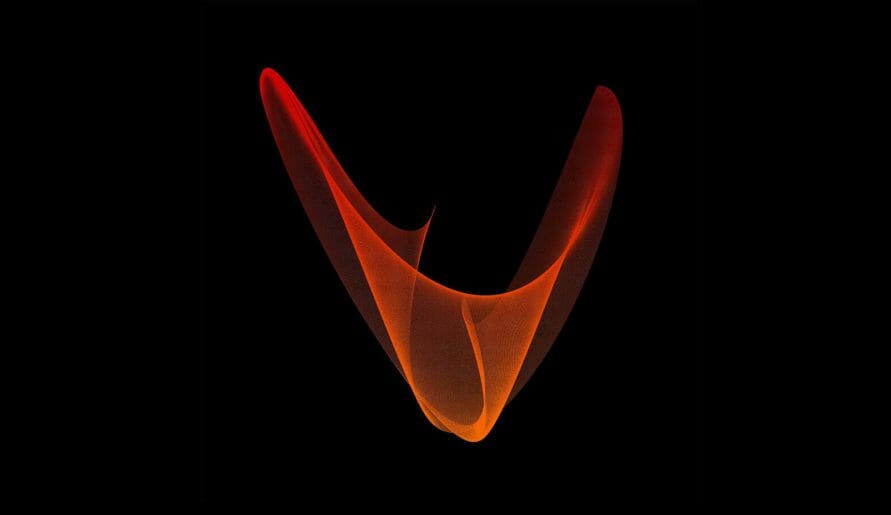

Volendo tuttavia rappresentare graficamente l’universo dei dati disponibili possiamo utilizzare, come dimensione d’analisi, i parametri di volume e complessità:

Leave A Comment