Alessandro Rezzani

Perchè analizzare i Big Data? Qual è il loro scopo?

Gli obiettivi dell’analisi dei Big Data L’analisi dei Big Data ha numerosi scopi e obiettivi, che possono essere riassunti sotto tre aspetti: Il business: i big data danno la possibilità di perseguire nuovi modelli di business o di ottenere sensibili vantaggi competitivi sul business tradizionale dell’azienda. La tecnologia: la dimensione e la complessità dei dati richiedono tecnologie adeguate, al fine di trarre

Modelli Big Data

Come si analizzano i Big Data? L’enorme quantità di dati complessi che prende il nome di Big Data non può essere analizzata con i tradizionali RDBMS (Relational Database Management System), poiché questi ultimi non sono in grado di gestirne né l’archiviazione né l’analisi in velocità. Al contrario, per analizzare i Big Data, gli operatori di mercato sono soliti utilizzare sistemi con elevata scalabilità e

Come creare valore con i Big Data

Big Data è un termine che identifica i dati che superano i limiti degli strumenti database tradizionali, ma anche le tecnologie volte ad estrarre conoscenza e valore da questa tipologia di dati. Mentre un tempo i Big Data erano prerogativa di poche, grandi aziende in campo informatico, che – consapevoli della loro importanza – investivano nella loro analisi una quantità enorme di risorse, oggi il termine è considerato di

Big Data per turismo

L’utilizzo dei Big Data nel turismo è, in qualche modo, simile a quello del settore Ho.Re.Ca., ossia relativo all’accoglienza e alla ristorazione. Attraverso l’analisi dell’infinita mole di dati, strutturati e non strutturati, che si sviluppano attraverso i vari canali internet, in diversi formati e a una velocità sostenibile solamente da tecnologie di nuova generazione, è possibile garantire alle aziende del

Dalla BI all’analisi predittiva

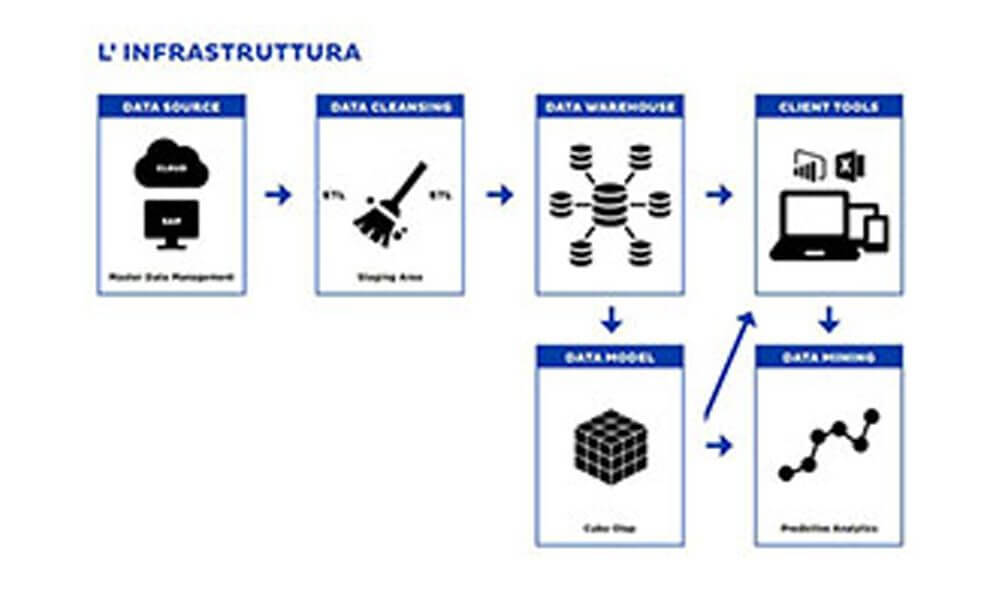

Comprendere e sfruttare il analisi predittiva per le decisioni aziendali analisi predittiva e Data warehouse Se esaminiamo come le modalità di analisi dei dati si sono evolute negli anni, notiamo come da indagini effettuate direttamente sulle fonti operazionali, si è passati, a partire dagli anni ’90, all’utilizzo di una base dati creata appositamente: il data warehouse. Con il data warehouse

Cosa sono i big data

Definizione di big data I big data sono dati che superano i limiti degli strumenti database tradizionali, ma con questo termine si intendono anche le tecnologie finalizzate ad estrarre da essi conoscenze e valore. In pratica, potremmo definire big data l’analisi di quantità incredibilmente grandi di informazioni. In considerazione della loro enorme estensione in termini di volume, ma anche delle

72esima edizione di Campus Party

18-22 Luglio 2018 Forum di Assago Dataskills partecipa alla 72esima edizione di Campus Party, un evento globale che connette migliaia di giovani imprenditori, studenti e investitori nel mercato della tecnologia. Lucrezia Noli, Big Data Scientist presso l’azienda, interviene con la sessione “Predictive Analytics in Action: from theory to applications”, commentata anche dal giornale Avvenire, che riporta l’intervista fatta a Lucrezia

Greci

Con un parco clienti attivo di 17,000 aziende su territorio mondiale, Greci è un brand made in Italy, leader nel settore dell’industria alimentare, che ha basato il suo successo sulla qualità

Discovering Machine Learning: Predictive Analytics Tools in Action

17-18 maggio 2018 presso Villa Lomellini Il 17 e 18 maggio 2018 presso la nostra sede di Montebello della Battaglia si è tenuto un workshop sul Machine Learning, finalizzato a una profonda comprensione delle diverse tecniche utilizzate per l’analisi predittiva dei grandi dati tramite l’ausilio di spiegazioni formali degli algoritmi, affiancate a casi pratici.

WPC 2018

27-28-29 Ottobre 2018 NH Hotel Centro Congressi Assago Dataskills partecipa a WPC 2018, la più grande conferenza italiana sulle tecnologie Microsoft, con un intervento di Lucrezia Noli, Big Data Scientist presso l’azienda, riguardante le tecniche di Deep Learning applicate alla Computer Vision.

Cos’è la business intelligence?

Si definisce la Business Intelligence (BI) come il processo di “trasformazione di dati e informazioni in conoscenza” al fine dell’utilizzo in processi decisionali strategici, in modo che questi siano supportati da informazioni coerenti, aggiornate e altamente precise. Business Intelligence: sistema di raccolta del patrimonio dati di un’azienda La Business Intelligence è un sistema di modelli, metodi, processi, persone e strumenti

Come la Business intelligence può risolvere le criticità aziendali – Case History

Nel PDF troverai un caso reale che dimostra come la business intelligence può risolvere le criticità aziendali.

Modelli di Data Mining

Come creare un modello di Data Mining Nella costruzione dei modelli di data mining applichiamo una metodologia di lavoro che prevede più fasi: La scelta dell’algoritmo di calcolo. Essa è basata sull’analisi del problema di data mining da risolvere La preparazione dei dati. Qualora l’algoritmo richieda elaborazioni particolari, è necessario preparare dati, applicando, per esempio procedimenti di discretizzazione, normalizzazione, creazione di

Il consulente di Business Intelligence non è un tradizionale consulente

Per Business Intelligence si intende il complesso processo di trasformazione dei dati e di informazioni in conoscenza concreta. L’analisi, la comprensione e l’assimilazione di questi dati permette, successivamente, il loro utilizzo in processi decisionali altamente strategici per il successo di un’azienda. L’importanza della Business Intelligence risiede nell’assoluta precisione dei dati che essa è in grado di fornire, nelle sue informazioni

Tutti i vantaggi e i benefici della Business Intelligence

Il principale vantaggio della Business Intelligence risiede nel miglioramento delle performance aziendali.

Utilizzo dei Big Data: l’Internet Of Things e le Smart City

Il concetto dell’Internet delle Cose (chiamato anche Internet of Things o IOT) è ormai sempre più diffuso ed, essenzialmente, fa riferimento a tutti quegli oggetti…

Workshop “Discovering Machine Learning: Predictive Analytics Tools in action”

Il 17 e 18 maggio 2018 presso la nostra sede di Montebello della Battaglia si terrà un workshop sul Machine Learning. Il workshop è finalizzato a una profonda comprensione delle diverse tecniche utilizzate per l’analisi predittiva dei grandi dati tramite l’ausilio di spiegazioni formali degli algoritmi, affiancate a casi pratici. Vedi i dettagli e iscriviti qui!

La Business Intelligence nel mondo della finanza

La Business Intelligence si rivela strumento fondamentale per i servizi finanziari e, in particolare, di banking.

Utilizzo dei Big Data: il settore Banking

Avendo ampiamente introdotto il concetto di Big Data negli articoli precedenti, inizieremo oggi ad esplorare alcuni casi interessanti relativi al loro utilizzo

Le tre V dei Big Data

Quali sono le caratteristiche dei big data? I big data sono disponibili in enormi volumi, si presentano con formati destrutturati e caratteristiche eterogenee e sono spesso prodotti a velocità estrema: i fattori che li identificano sono dunque primariamente Volume, Variety, Velocity (volume, varietà e velocità). Analizziamo meglio questi tre parametri: Volume Equivale alla quantità dei big data, sia che essi